- Deutsch

-

EnglishDeutschItaliaFrançais日本語한국의русскийSvenskaNederlandespañolPortuguêspolskiSuomiGaeilgeSlovenskáSlovenijaČeštinaMelayuMagyarországHrvatskaDanskromânescIndonesiaΕλλάδαБългарски езикAfrikaansIsiXhosaisiZululietuviųMaoriKongeriketМонголулсO'zbekTiếng ViệtहिंदीاردوKurdîCatalàBosnaEuskeraالعربيةفارسیCorsaChicheŵaעִבְרִיתLatviešuHausaБеларусьአማርኛRepublika e ShqipërisëEesti Vabariikíslenskaမြန်မာМакедонскиLëtzebuergeschსაქართველოCambodiaPilipinoAzərbaycanພາສາລາວবাংলা ভাষারپښتوmalaɡasʲКыргыз тилиAyitiҚазақшаSamoaසිංහලภาษาไทยУкраїнаKiswahiliCрпскиGalegoनेपालीSesothoТоҷикӣTürk diliગુજરાતીಕನ್ನಡkannaḍaमराठी

Neuronale Netzwerkbeschleuniger für Lattice-FPGAs

Beide zielen darauf ab, neuronale Netze in Endverbraucher- und industriellen Netzprodukten zu implementieren. Sie eignen sich nicht für Netzwerktrainings, die an anderer Stelle durchgeführt werden müssen.

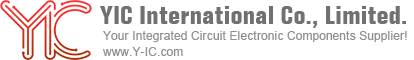

Der "Binarized Neural Network (BNN) Accelerator" unterstützt 1-Bit-Gewichte, hat eine 1-Bit-Aktivierungsquantisierung und ist für die Verwendung mit den iCE40 UltraPlus-FPGAs des Unternehmens ausgelegt.

Die Kombination aus Beschleuniger und FPGA ist für permanente Anwendungen wie die Erkennung verbaler Schlüsselphrasen, die Gesichtserkennung und die Objekterkennung vorgesehen.

Die prognostizierten Anwendungsparameter für BNN + iCE40 UltraPlus sind:

Die prognostizierten Anwendungsparameter für BNN + iCE40 UltraPlus sind:

- 1bit neuronales Netzwerk

- 1-10mW aktiver Verbrauch

- 5,5 mm2 Stellfläche

- ~ 1 US-Dollar

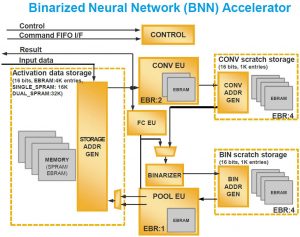

Das zweite Produkt, der "Convolutional Neural Network (CNN) Accelerator", unterstützt eine Auswahl von 1-, 8- und 16-Bit-Daten sowohl für die Gewichtung als auch für die Aktivierung.

Um FPGA-Ressourcen zu sparen, können verschiedene Wortbreiten (1, 8 oder 16 Bit) in verschiedenen Schichten des neuronalen Netzes gemischt und abgeglichen werden.

Diese Kombination aus Beschleuniger und FPGA ist für Anwendungen vorgesehen, einschließlich Gesichtsverfolgung, Objektverfolgung, Geschwindigkeitszeichenerkennung und Objektzählung.

Die vorhergesagten Anwendungsparameter für CNN + ECP5 sind:

- 1, 8 oder 16bit Netzwerk

- <1W active consumption

- 100mm2 Stellfläche

- ~ 10 US-Dollar

Für die Softwareentwicklung führt das Unternehmen einen neuronalen Netzwerkcompiler ein, der sowohl mit Caffe- als auch mit TensorFlow-Netzwerkentwicklungssystemen kompatibel ist.

Laut Deepak Boppana, Marketingleiter von Lattice, benötigt der Compiler keine RTL-Vorkenntnisse und analysiert und simuliert auch Entwürfe.

Laut Boppana soll der Compiler neben der Radiant-Entwicklungsumgebung des Unternehmens für die BNN + iCE40 UltraPlus-Kombination oder der Diamond-Entwicklungsumgebung für CNN + EC5P verwendet werden.

Für Kunden, die sich nicht sicher sind, wie sie eine neuronale netzwerkbasierte Anwendung entwickeln sollen, arbeitet das Unternehmen mit Design-Dienstleistungsunternehmen wie Colorado Engineering, Wipro, Softnautincs und VectorBlox zusammen.

Hardware-Entwicklungskarten sind bereits für den iCE40 UltraPlus und ECP5 verfügbar.

Schnittstellenüberbrückungs- und Datenaggregationsanwendungen werden für hochvolumige IoT-Anwendungen erwartet, einschließlich intelligenter Lautsprecher, Überwachungskameras, Industrieroboter und Drohnen.

Referenzdesigns werden bereitgestellt für: Gesichtserkennung, Schlüsselphrasenerkennung (iCE40 UltraPlus) und für den EC5P: Objektzählung, Gesichtsverfolgung und Geschwindigkeitszeichenerkennung.

Die Beschleuniger tragen die MarkesensAI‘.