- Deutsch

-

EnglishDeutschItaliaFrançais日本語한국의русскийSvenskaNederlandespañolPortuguêspolskiSuomiGaeilgeSlovenskáSlovenijaČeštinaMelayuMagyarországHrvatskaDanskromânescIndonesiaΕλλάδαБългарски езикAfrikaansIsiXhosaisiZululietuviųMaoriKongeriketМонголулсO'zbekTiếng ViệtहिंदीاردوKurdîCatalàBosnaEuskeraالعربيةفارسیCorsaChicheŵaעִבְרִיתLatviešuHausaБеларусьአማርኛRepublika e ShqipërisëEesti Vabariikíslenskaမြန်မာМакедонскиLëtzebuergeschსაქართველოCambodiaPilipinoAzərbaycanພາສາລາວবাংলা ভাষারپښتوmalaɡasʲКыргыз тилиAyitiҚазақшаSamoaසිංහලภาษาไทยУкраїнаKiswahiliCрпскиGalegoनेपालीSesothoТоҷикӣTürk diliગુજરાતીಕನ್ನಡkannaḍaमराठी

Embedded Vision-Systeme auf den Markt bringen

Die visuelle Eingabe ist wohl die reichste Quelle für Sensorinformationen. Wissenschaftler und Ingenieure versuchen seit vielen Jahrzehnten, Bildverarbeitungstechnologien zu verstehen und zu nutzen, indem sie Algorithmen für Bildverarbeitungsanwendungen entwickeln, die es Rechenmaschinen ermöglichen zu "sehen".

Die ersten echten kommerziellen Anwendungen - weithin bekannt als Machine Vision - analysierten sich schnell bewegende Objekte, um Fehler in Produkten zu untersuchen und zu erkennen. Verbesserungen der Verarbeitungsleistung, des Energieverbrauchs, von Bildsensoren, Computeralgorithmen und maschinellem Lernen haben jedoch die Sicht auf ein viel höheres Niveau erhöht.

Die heutige Kombination von eingebetteten Systemen und Computer Vision hat zur Realisierung von Embedded Vision Systemen geführt. In den nächsten Jahren wird es eine rasante Verbreitung von Technologien für die eingebettete Bildverarbeitung geben, einschließlich solcher, die auf Schwachlichtbedingungen oder hochauflösende Bildgebung ausgerichtet sind, oder High-End-Anwendungen, die auf speziell entwickelten Verarbeitungsmaschinen basieren. Eine steigende Anzahl von Produkten wird mit visuellen Inputs für eine breite Palette von Anwendungen in den Märkten für Verbraucher, Automobile, Industrie, Gesundheitswesen und Heimautomatisierung entstehen.

Neue Welle

Das Internet der Dinge (IoT) verändert die Elektronikindustrie dramatisch mit der Erwartung, dass Milliarden von Geräten miteinander verbunden werden. Das Ziel von IoT ist es, Geräte für Benutzer überall auf der Welt intelligent und zugänglich zu machen. Geräte werden oft als intelligent erkannt, wenn sie unser Leben stark vereinfachen, zum Beispiel automatisch einen Bewohner mit einem Bildtelefon erkennen und diese Person in ein Gebäude eintreten lassen, als nur ein Beispiel aus vielen neuen Fähigkeiten.

Im Allgemeinen sind Geräte viel wertvoller, wenn sie mit der physischen Welt interagieren, und visuelle Eingaben sind besonders leistungsstark: Sie erfassen viele Informationen und können bei der Interaktion mit ihrer physischen Umgebung helfen. Ein klassisches Beispiel ist die Robotik, die von Anfang an Bildsensoren verwendet hat. Die Bildsensoren - der Eingang zu einem System - sind die Augen eines Roboters und können einem Roboter helfen, Motoren mit hoher Effizienz zu steuern - die Leistung eines Systems.

Darüber hinaus ermöglichen jüngste Entwicklungen beim maschinellen Lernen mit konvolutionellen neuronalen Netzen (CNNs) und anderen neuronalen Netzwerktechnologien die Entwicklung selbstlernender intelligenter Bildverarbeitungssysteme.

Herausforderungen

Eingebettete Vision hat das Potenzial, in fast jedem Elektronikmarkt einen großen Wert zu schaffen und wird mit fortschreitender Verbesserung von Hardware und Software schnell wachsen. Bei der Entwicklung einer Embedded-Vision-Anwendung über das gesamte System hinweg sind jedoch viele Herausforderungen verbunden.

Aufgrund seiner Qualität müssen Rohbilddaten, ob Video- oder Standbilder, optimiert und verarbeitet werden. Wenn die Qualität der Linse beispielsweise nicht gut genug ist, wird dies das gesamte Bildverarbeitungselement beeinflussen. Darüber hinaus kann die Menge der erfassten Daten enorm sein, insbesondere bei hochauflösendem Video und Echtzeitverarbeitung. Viele High-End-Vision-Anwendungen erfordern parallele Verarbeitungssysteme oder dedizierte Hardware wie GPUs, DSPs, FPGAs oder Co-Prozessoren. Embedded-Vision-Systeme sind jedoch häufig in Bezug auf Kosten, Größe und Stromverbrauch stark eingeschränkt, und während eine High-End-Verarbeitungsmaschine die Macht haben könnte, könnte sie auch für eine Anwendung zu teuer oder leistungshungrig sein.

Es ist wichtig zu wissen, dass Embedded Vision unter realen Bedingungen arbeitet, die sich ständig ändern, einschließlich Lichtniveaus und Bewegung oder Orientierung. In diesen Situationen ist der Einsatz spezialisierter Bildverarbeitungsalgorithmen zur Steuerung der Daten entscheidend. Sich nur auf Simulationen zu verlassen, wird nicht funktionieren, und Tests in der realen Welt sind erforderlich, was zeitaufwändig sein kann. Dies gilt insbesondere für Anwendungen in den Bereichen Automotive, Sicherheit und Robotik.

Eingebettete Bildverarbeitungssysteme

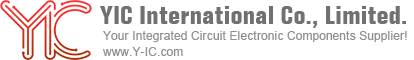

Eingebettete Bildverarbeitungssysteme umfassen eine breite Palette von Komponenten, und es gibt viele verschiedene Möglichkeiten, diese zu integrieren, aber in erster Linie umfassen sie Bildverarbeitungs-, Verarbeitungs- und Computer-Vision-Technologien.Abbildung 1 - Ein typisches Embedded-Vision-System auf hoher Ebene

Am Eingangsende des Systems sind CMOS und ladungsgekoppeltes Bauelement (CCD) die zwei führenden Technologien, die heute für die Bilderfassung verfügbar sind. Während CCD insgesamt eine höhere Qualität liefert, hat die Verbesserung der CMOS-Bildtechnologien in den letzten zehn Jahren die Lücke geschlossen. Zusätzlich zu den geringen Lichtlevel-Handhabungsfähigkeiten haben die verbesserte Bildqualität, der niedrigere Stromverbrauch und die niedrigeren Kosten dazu geführt, dass der Einsatz von CMOS-Sensoren wesentlich höher ist als bei CCD-Sensoren. Auch die CMOS-Technologie entwickelt sich ständig weiter und bietet kontinuierliche Verbesserungen bei der Pixelgrößenreduzierung und -auflösung mit der erforderlichen schnelleren Verbindung und Bandbreite. Darüber hinaus werden immer kleinere Bildsensorpakete und -module verfügbar, die zunehmend kompakte Dual-Kamera-Lösungen und Stereo-Vision-Implementierungen ermöglichen, um Verzerrungen zu kompensieren, Tiefe zu erkennen, den Dynamikbereich zu verbessern und die Schärfe zu verbessern.

Die Wahl des Prozessors muss durch Aspekte wie Echtzeitleistung, Stromverbrauch, Bildgenauigkeit und Komplexität des Algorithmus bestimmt werden. Die Verarbeitungsleistung und die Bildverarbeitungsalgorithmen wurden kontinuierlich verbessert und die Integration von Simultaneous Localization and Mapping (SLAM) für Automobil-, Robotik- und Drohnenanwendungen wurde verbessert.

Lokaler Speicher wird auch benötigt, um Bilder zu vergleichen oder Bilddaten für zukünftige Analysen zu speichern. Wenn entweder einige Elemente oder alle aufgenommenen Bilddaten gespeichert werden, werden sowohl flüchtige Speicher als auch nichtflüchtige Speichertypen üblicherweise in Abbildungssystemen verwendet. Spezialisierte Bildverarbeitungsalgorithmen sind ebenfalls ein Schlüsselelement des Systems, beispielsweise zur Steuerung der Videobildeingabe und zur Verbesserung des Videos für bestimmte Anforderungen, wie z. B. die Verbesserung der Farbverstärkung und Objekterkennung.

Seit der Einführung der OpenCV-Open-Source-Bibliothek für Computer Vision vor einigen Jahren hat sich der Prozess zur Entwicklung und Implementierung von Algorithmen dramatisch verändert. OpenCV enthält Programmcode, einschließlich C / C ++ - Funktionen, die sich auf visionbasierte Anwendungen konzentrieren und das Portieren und Ausführen von Algorithmen auf eingebetteten Prozessoren erleichtern. Viele Drittanbieter bieten auf OpenCV oder ähnlichen Bibliotheken oder sogar Frameworks basierende Bildverarbeitungs- und Videoverarbeitungslösungen für viele verschiedene Anwendungen an. Silicon-Anbieter bieten in der Regel auch Bildverarbeitungsbibliotheken an, um die integrierten Bildverarbeitungsanwendungen ihrer Produkte zu verbessern.

Ein weiteres und zunehmend wichtiges Element, insbesondere in der Ära des IoT, ist die Konnektivität - entweder kabelgebunden oder drahtlos, abhängig von der Anwendung und ihren Anforderungen. Eine weitere Überlegung ist die Bereitstellung von Software, die algorithmische Analysen auf cloudbasierten Servern ausführt.

Insgesamt ist es entscheidend, die richtigen Elemente für das System und die Anwendung auszuwählen und dann mit der Feinabstimmung all dieser Teile einschließlich Hardware, Software und Algorithmen fortzufahren. Dies ist nicht immer so einfach und aufgrund der Komplexität von Embedded Vision müssen Entwickler unbedingt professionelle Tools verwenden, um Entwicklungskosten, Zeit und Risiko zu reduzieren, um eingebettete Vision-Projekte schnell auf den Markt zu bringen.

Komplette Entwicklung

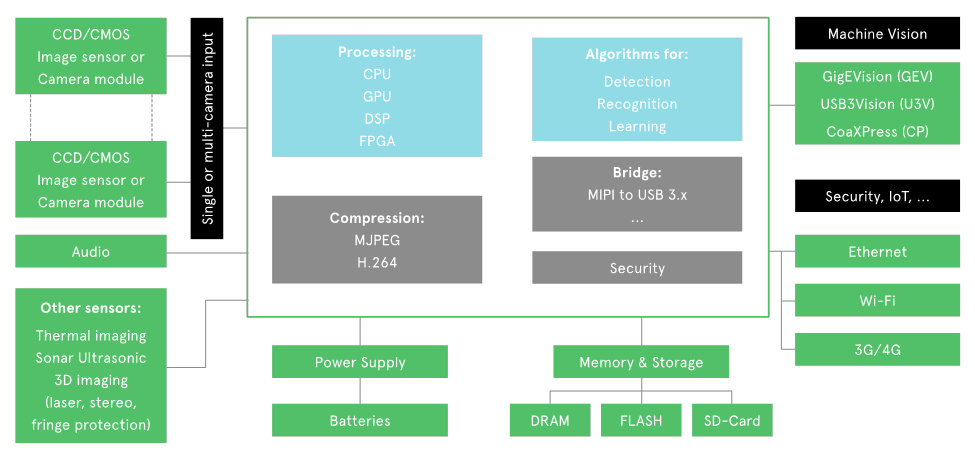

Avnet Silica verfügt über umfangreiche Erfahrung bei der Unterstützung von Kunden bei der Entwicklung von Embedded-Vision-Anwendungen. Das Unternehmen bietet nahezu alle Bausteine für ein vollständiges Embedded-Vision-System, einschließlich optimierter Hardware und Software, Treiber und Anwendungen. Die Bibliothek der verfügbaren Blöcke reicht vom Bildsensor oder Kameramodul am Eingang bis hin zu dedizierter Hardware einschließlich der Prozessoren, Speicher und Leistungskomponenten, die benötigt werden, um kritische Verarbeitungs- und Stromverbrauchsanforderungen zu erfüllen. Alle diese Blöcke sind außerdem mit Softwareentwicklungswerkzeugen, Kameratreibersoftware, beispielhaften Anwendungsreferenzdesigns und umfangreichem Know-how in Bildverarbeitungssoftware und -algorithmen verbunden.

Abbildung 2 - Eingebettete Vision-Lösungen

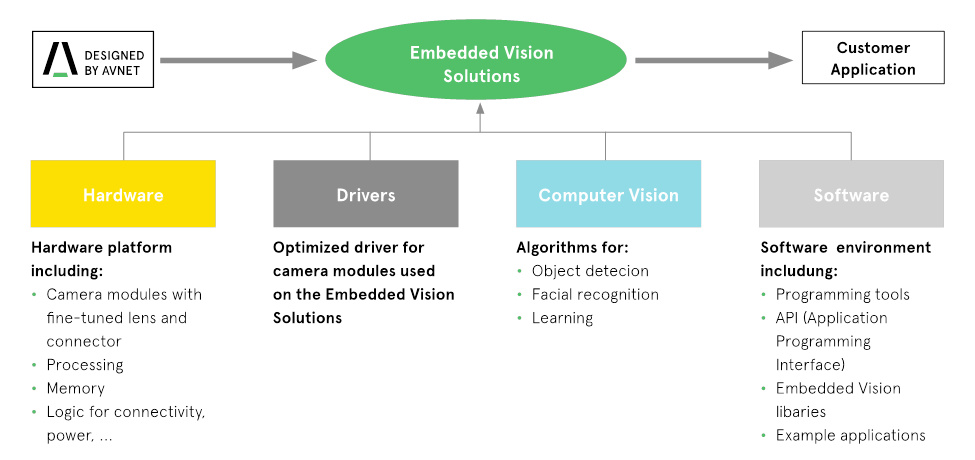

Neben der Entwicklung kundenspezifischer Lösungen, die den Kunden beim Aufbau ihrer eingebetteten Vision-Plattformen und Produkte helfen, hat Avnet Silica auch eine breite Palette von Standard-Kameraentwicklungslösungen entwickelt. Zum Beispiel baut das Picozed Embedded Vision Kit auf dem hochflexiblen PicoZed System-on-Modul (SoM) auf, das wiederum auf dem programmierbaren System-on-Chip (SoC) Xilinx Zynq-7000 basiert. Das PicoZed-Kit ist ideal für Machine-Vision-Anwendungen und umfasst alle Hardware-, Software- und IP-Komponenten, die für die Entwicklung von benutzerdefinierten Videoanwendungen erforderlich sind. Es unterstützt reVISION, einen rekonfigurierbaren Beschleunigungs-Stack, der für Computer Vision- und Vision-gesteuerte Machine-Learning-Anwendungen optimiert wurde. Der Stack enthält Ressourcen für die Entwicklung von Plattformen, Algorithmen und Anwendungen, verfügt über hardwarebeschleunigte OpenCV-Funktionen und unterstützt die meisten gängigen neuronalen Netze.Abbildung 3 - Picozed Embedded Vision Kit

Ein zweites Beispiel ist das Avnet Silica STM32F7 Kamera-Entwicklungskit. Low-Cost- und Mbed-fähig, bietet einen niedrigen Stromverbrauch, USB-Schnittstelle, ein 4,3-Zoll-Farb-kapazitives Touchscreen-Display und die gesamte notwendige Hardware und Software, um die schnelle Entwicklung von Embedded Vision für Internet of Things (IoT) zu ermöglichen. Heimautomatisierung und andere Videoanwendungen. Ein drittes Kit ist das energiesparende Kinetis-Kit - basierend auf dem NXP Kinetics K82F Cortex-M4-Mikrocontroller - mit einem Miniatur-VGA-Kameramodul mit Flex-Anschluss, 90 ° horizontalem Sichtfeld und IR-Filter und kann Standbilder aufnehmen oder streamen Sie Echtzeit-Video mit niedriger Auflösung.

Michaël Uyttersprot ist Technical Marketing Manager bei Avnet Silica, die weitere Produkte für diese Standard-Kits entwickeln und erweitern wird, um eine breite Auswahl an fortschrittlichen Embedded-Vision-Lösungen zu ermöglichen. Weitere Informationen finden Sie unter:

https://www.avnet-silica.com/embedded-vision